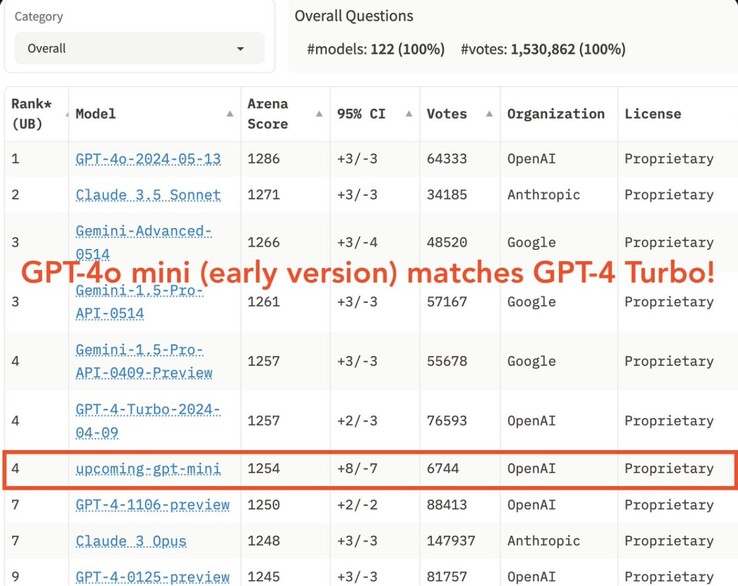

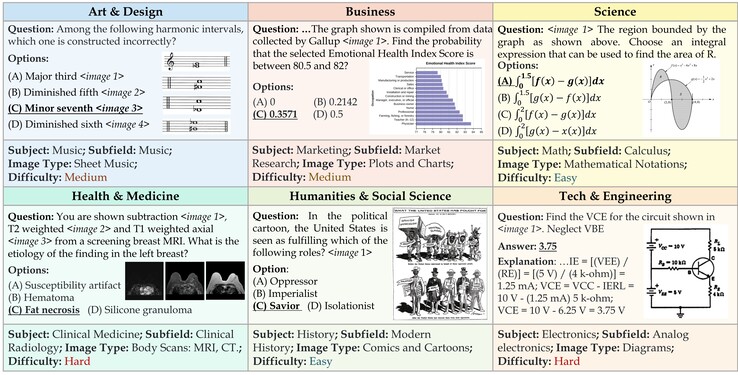

A OpenAI revelou o GPT-4o mini com um preço mais de 25 vezes menor do que o GPT-4o, o mais bem classificado, abrindo o acesso à IA de qualidade para mais empresas e usuários. O GPT-4o mini foi classificado de forma independente no site entre os 10 modelos de IA mais capazes disponíveis atualmente. O GPT-4o mini tem um bom desempenho em uma série de benchmarks de IA, apesar de ser um modelo LLM pequeno.

Um modelo de linguagem grande (LLM) é criado após o treinamento em milhões de documentos e forma a base para um chatbot de IA como o ChatGPT. O modelo contém vetores matemáticos que associam a probabilidade de ocorrência de palavras, imagens e outros elementos entre si. Por exemplo, a probabilidade de "gelo" aparecer ao lado de "creme" é muito maior do que aparecer ao lado de "pedra". No entanto, um grande LLM utiliza muita potência de computação e energia para responder às solicitações do usuário, o que equivale a um alto custo para os usuários. A redução dos LLMs pode torná-los menores, mais baratos e mais ecológicos, com a contrapartida de respostas menos precisas.

Os leitores que não sabem como usar a IA para realizar melhor as tarefas comerciais ou ganhar mais dinheiro podem ler este livro na Amazon.

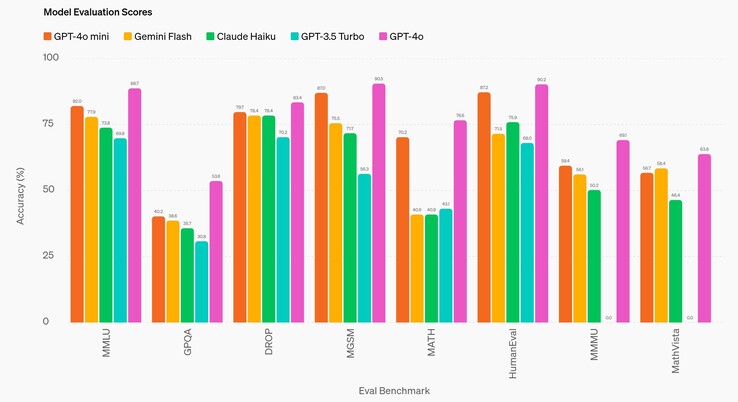

Em uma comparação direta com o site GPT-4oo melhor LLM da OpenAI lançado em 2024, o GPT-4o mini produz consistentemente respostas menos precisas. Quando comparado ao GPT-3.5 Turbo de 2022, o GPT-4o mini tem um desempenho consistentemente melhor. Em uma variedade de benchmarks de IA de nível universitário (DROP, HumanEval, MATH, MathVista, MGSM, MMLUe MMMU), o modelo responde às perguntas com precisão em cerca de 60 a 80% das vezes. Somente no teste de pós-graduação de doutorado (GPQA) que sua precisão cai para aproximadamente 40%, ou seja, um pouco melhor do que um não especialista que procura uma resposta on-line.

É importante ressaltar que, embora o GPT-4o custe US$ 5/1 milhão de tokens de entrada e US$ 15/1 milhão de tokens de saída, o GPT-4o mini custa US$ 0,15/1 milhão de entrada e US$ 0,60/1 milhão de saída (1.000 tokens equivalem a aproximadamente 750 palavras). Isso é mais barato do que cerca de oitenta LLMs comuns em uso atualmente, com exceção des comuns em uso atualmente, com exceção do mistral-embed.

O GPT-4o mini tem uma janela de contexto de entrada de 128K tokens, que é a quantidade de texto que pode ser analisada de uma só vez, portanto, a análise de grandes volumes de documentos comerciais e jurídicos é limitada. A janela de saída é limitada a 16 mil tokens. O modelo também tem um limite de conhecimento de outubro de 2023, portanto, notícias, eventos e descobertas que ocorram após essa data são desconhecidos para a IA e não podem ser usados para responder aos prompts.

Os leitores que ainda estão esperando que os robôs humanoides de IA sejam honestos e cozinhem para eles, como o protótipo 1X Neoterão que se contentar com robôs sem IA(como este aspirador de pó da Amazon) enquanto isso.

18 de julho de 2024

GPT-4o mini: avançando na inteligência econômica

Apresentando nosso modelo pequeno mais econômico

A OpenAI tem o compromisso de tornar a inteligência tão amplamente acessível quanto possível. Hoje, estamos anunciando o GPT-4o mini, nosso modelo pequeno mais econômico. Esperamos que o GPT-4o mini expanda significativamente a gama de aplicativos criados com IA, tornando a inteligência muito mais acessível. O GPT-4o mini tem 82% de pontuação no MMLU e atualmente supera o GPT-41 em preferências de bate-papo na tabela de classificação LMSYS(abre em uma nova janela). Seu preço é de 15 centavos por milhão de tokens de entrada e 60 centavos por milhão de tokens de saída, uma ordem de magnitude mais acessível do que os modelos de fronteira anteriores e mais de 60% mais barato do que o GPT-3.5 Turbo.

O GPT-4o mini permite uma ampla gama de tarefas com seu baixo custo e latência, como aplicativos que encadeiam ou paralelizam várias chamadas de modelo (por exemplo, chamando várias APIs), passam um grande volume de contexto para o modelo (por exemplo, base de código completa ou histórico de conversas) ou interagem com os clientes por meio de respostas de texto rápidas e em tempo real (por exemplo, chatbots de suporte ao cliente).

Atualmente, o GPT-4o mini oferece suporte a texto e visão na API, com suporte para entradas e saídas de texto, imagem, vídeo e áudio no futuro. O modelo tem uma janela de contexto de 128 mil tokens, suporta até 16 mil tokens de saída por solicitação e tem conhecimento até outubro de 2023. Graças ao tokenizador aprimorado compartilhado com o GPT-4o, o tratamento de textos que não estejam em inglês agora é ainda mais econômico.

Um modelo pequeno com inteligência textual superior e raciocínio multimodal

O GPT-4o mini supera o GPT-3.5 Turbo e outros modelos pequenos em benchmarks acadêmicos, tanto em inteligência textual quanto em raciocínio multimodal, e suporta a mesma variedade de idiomas que o GPT-4o. Ele também demonstra um bom desempenho na chamada de funções, o que pode permitir que os desenvolvedores criem aplicativos que busquem dados ou realizem ações com sistemas externos, e um melhor desempenho de contexto longo em comparação com o GPT-3.5 Turbo.

O GPT-4o mini foi avaliado em vários benchmarks importantes2.

Tarefas de raciocínio: O GPT-4o mini é melhor do que outros modelos pequenos em tarefas de raciocínio que envolvem texto e visão, com pontuação de 82,0% no MMLU, um benchmark de inteligência textual e raciocínio, em comparação com 77,9% do Gemini Flash e 73,8% do Claude Haiku.

Proficiência em matemática e codificação: O GPT-4o mini se destaca em tarefas de raciocínio matemático e codificação, superando os modelos pequenos anteriores no mercado. No MGSM, que mede o raciocínio matemático, o GPT-4o mini obteve 87,0%, em comparação com 75,5% do Gemini Flash e 71,7% do Claude Haiku. O GPT-4o mini obteve 87,2% de pontuação no HumanEval, que mede o desempenho de codificação, em comparação com 71,5% do Gemini Flash e 75,9% do Claude Haiku.

Raciocínio multimodal: O GPT-4o mini também apresenta um bom desempenho no MMMU, um teste de raciocínio multimodal, com 59,4% de pontuação, em comparação com 56,1% do Gemini Flash e 50,2% do Claude Haiku.

Como parte do processo de desenvolvimento do nosso modelo, trabalhamos com vários parceiros confiáveis para entender melhor os casos de uso e as limitações do GPT-4o mini. Fizemos parcerias com empresas como a Ramp(abre em uma nova janela) e a Superhuman(abre em uma nova janela), que descobriram que o GPT-4o mini tem um desempenho significativamente melhor do que o GPT-3.5 Turbo em tarefas como extração de dados estruturados de arquivos de recibo ou geração de respostas de e-mail de alta qualidade quando fornecidas com o histórico de threads.

Medidas de segurança incorporadas

A segurança é incorporada aos nossos modelos desde o início e reforçada em cada etapa do nosso processo de desenvolvimento. No pré-treinamento, filtramos(abre em uma nova janela) as informações com as quais não queremos que nossos modelos aprendam ou produzam, como discurso de ódio, conteúdo adulto, sites que agregam principalmente informações pessoais e spam. No pós-treinamento, alinhamos o comportamento do modelo às nossas políticas usando técnicas como o aprendizado por reforço com feedback humano (RLHF) para melhorar a precisão e a confiabilidade das respostas dos modelos.

O GPT-4o mini tem as mesmas atenuações de segurança incorporadas ao GPT-4o, que avaliamos cuidadosamente por meio de avaliações automatizadas e humanas, de acordo com nossa Estrutura de Preparação e em consonância com nossos compromissos voluntários. Mais de 70 especialistas externos em áreas como psicologia social e desinformação testaram o GPT-4o para identificar riscos potenciais, os quais abordamos e planejamos compartilhar os detalhes no próximo cartão do sistema GPT-4o e no scorecard de preparação. Os insights dessas avaliações de especialistas ajudaram a melhorar a segurança do GPT-4o e do GPT-4o mini.

Com base nesses aprendizados, nossas equipes também trabalharam para melhorar a segurança do GPT-4o mini usando novas técnicas informadas por nossa pesquisa. O GPT-4o mini na API é o primeiro modelo a aplicar nosso método de hierarquia de instruções(abre em uma nova janela), que ajuda a melhorar a capacidade do modelo de resistir a jailbreaks, injeções de prompt e extrações de prompt do sistema. Isso torna as respostas do modelo mais confiáveis e ajuda a torná-lo mais seguro para uso em aplicativos em escala.

Continuaremos a monitorar como o GPT-4o mini está sendo usado e melhoraremos a segurança do modelo à medida que identificarmos novos riscos.

Disponibilidade e preços

O GPT-4o mini já está disponível como um modelo de texto e visão na API Assistants, na API Chat Completions e na API Batch. Os desenvolvedores pagam 15 centavos por 1 milhão de tokens de entrada e 60 centavos por 1 milhão de tokens de saída (aproximadamente o equivalente a 2.500 páginas em um livro padrão). Planejamos implementar o ajuste fino para o GPT-4o mini nos próximos dias.

No ChatGPT, os usuários Free, Plus e Team poderão acessar o GPT-4o mini a partir de hoje, no lugar do GPT-3.5. Os usuários corporativos também terão acesso a partir da próxima semana, em linha com nossa missão de tornar os benefícios da IA acessíveis a todos.

O que vem a seguir

Nos últimos anos, testemunhamos avanços notáveis na inteligência de IA, aliados a reduções substanciais de custo. Por exemplo, o custo por token do GPT-4o mini caiu 99% desde o text-davinci-003, um modelo menos capaz introduzido em 2022. Temos o compromisso de continuar essa trajetória de redução de custos e, ao mesmo tempo, aprimorar os recursos do modelo.

Vislumbramos um futuro em que os modelos se tornem perfeitamente integrados em todos os aplicativos e em todos os sites. O GPT-4o mini está abrindo caminho para que os desenvolvedores criem e dimensionem aplicativos avançados de IA de forma mais eficiente e acessível. O futuro da IA está se tornando mais acessível, confiável e incorporado em nossas experiências digitais diárias, e estamos entusiasmados em continuar a liderar o caminho.

Autor

OpenAI

Agradecimentos

Líderes: Jacob Menick, Kevin Lu, Shengjia Zhao, Eric Wallace, Hongyu Ren, Haitang Hu, Nick Stathas, Felipe Petroski Tal

Líder de programa: Mianna Chen

Contribuições registradas em openai.com/gpt-4o-contributions/

Notas de rodapé

1

Em 18 de julho de 2024, uma versão anterior do GPT-4o mini superou o GPT-4T 01-25.

2

Os números de avaliação do GPT-4o mini são calculados usando nosso repositório simple-evals(abre em uma nova janela) com o prompt de mensagem do sistema do assistente de API. Para os modelos da concorrência, pegamos o número máximo sobre o número relatado (se disponível), a tabela de classificação HELM(abre em uma nova janela) e nossa própria reprodução via simple-evals.

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros

![A impressão digital da OpenAI também é considerada 99,9% precisa (Fonte da imagem: OpenAI [editado])](fileadmin/_processed_/1/6/csm_OpenAI-ChatGPT_c463113f39.jpg)