A Manus AI lançou seu novo agente geral de IA capaz de pesquisar de forma independente respostas a solicitações complexas, aproveitando vários modelos de linguagem grande (LLMs) de IA em paralelo. A IA está disponível no momento pelo site , solicitando um convite.

Os chatbots comuns, como o OpenAI ChatGPT, o Microsoft CoPilot e o Anthropic Claude, são treinados em um conjunto fixo de dados, portanto, seu conhecimento é limitado. Perguntas sem respostas em seu conjunto de dados de treinamento não podem ser respondidas, embora algumas empresas tentem expandir os chatbots permitindo que eles acessem a Internet para obter as informações mais recentes. Ainda assim, esses chatbots não conseguem responder a solicitações complexas que exigem a solução de problemas.

Algumas empresas de IA tentaram resolver isso permitindo que a IA pensasse nos problemas passo a passo, analisasse os dados que encontra on-line e sintetizasse uma resposta. O OpenAI Deep Research é um desses agentes de IA que foi lançado no mês passado, e o Manus AI é o mais recente.

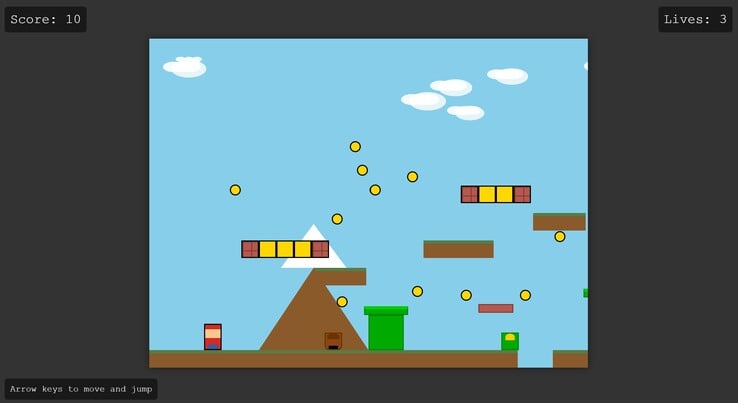

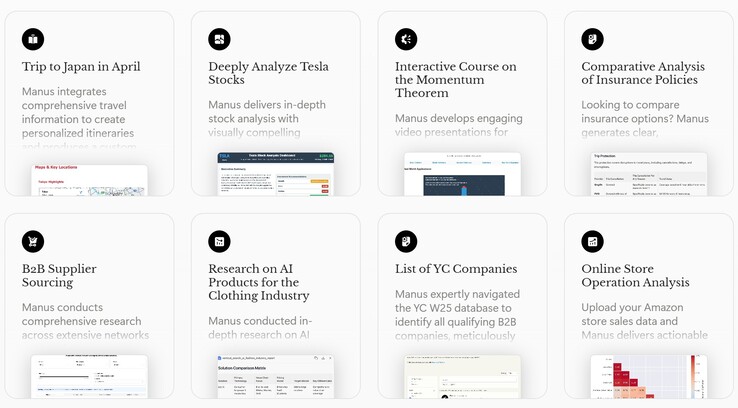

Diferentemente da oferta da OpenAI, o agente da Manus usa vários LLMs de IA, beneficiando-se assim das vantagens que cada um oferece. Os prompts são automaticamente divididos em tarefas menores que são trabalhadas em paralelo. Os usuários podem acompanhar o raciocínio da IA à medida que ela começa a trabalhar automaticamente nos problemas, passo a passo. O agente pode produzir não apenas respostas de texto, mas também planilhas, gráficos interativos, páginas da Web e videogames.

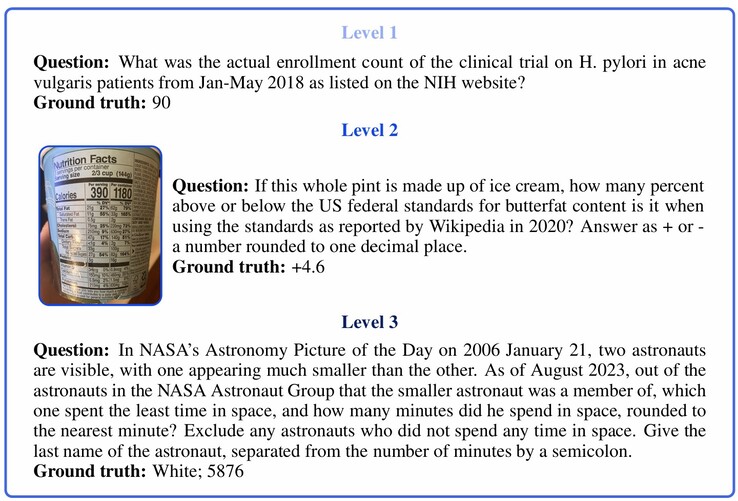

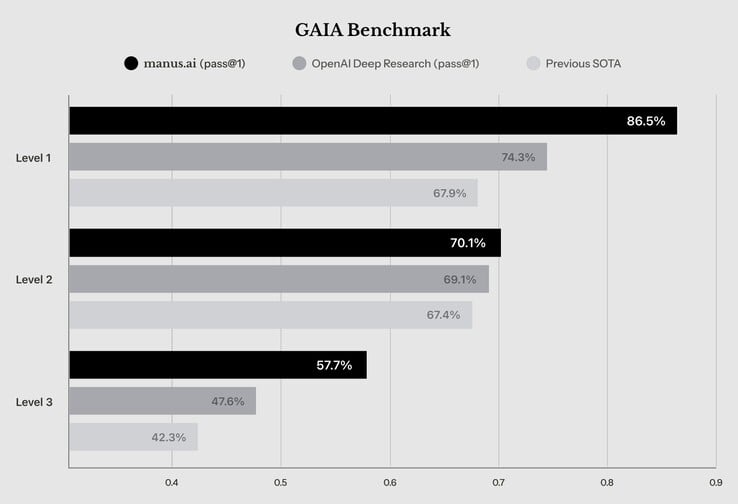

Embora o agente da Manus AI tenha obtido uma pontuação de apenas 57,7% nos prompts de Nível 3 no benchmark GAIA AI, um teste de perguntas do mundo real que até mesmo os seres humanos têm dificuldade em responder, o agente de IA é capaz de responder corretamente aos prompts mais fáceis de Nível 1 e 2 em mais de 70% das vezes. De acordo com a Manus AI, seu desempenho é melhor do que o de outras IAs capazes de pesquisar respostas atualmente.

Fonte(s)

Os Top 10

» Os Top 10 Portáteis Multimídia

» Os Top 10 Portáteis de Jogos

» Os Top 10 Portáteis Leves para Jogos

» Os Top 10 Portáteis Acessíveis de Escritório/Empresariais

» Os Top 10 Portáteis Premium de Escritório/Empresariais

» Os Top 10 dos Portáteis Workstation

» Os Top 10 Subportáteis

» Os Top 10 Ultrabooks

» Os Top 10 Conversíveis

» Os Top 10 Tablets

» Os Top 10 Smartphones

» A melhores Telas de Portáteis Analisadas Pela Notebookcheck

» Top 10 dos portáteis abaixo dos 500 Euros da Notebookcheck

» Top 10 dos Portáteis abaixo dos 300 Euros